Dr. M. Sonderegger

Dr. M. SondereggerTel: +41 52 622 22 55

Validierungsprobleme?

Gerne helfen wir Ihnen weiter.

Wieso validieren?

Modernes Qualitäts-Management erwartet häufig eine Null-Fehler Produktion. Dies ist für automatische Prozesse auch nötig, wie dies Qualitäts-Prüfsystem von zeigt. Es handelt sich dabei um grüne Verschlüsse für die Getränkeindustrie. So kam es manchmal vor, dass solch ein Verschluss um 1/10mm zu hoch war. Dies hatte dann beim Getränkeabfüller zur Folge, dass die Verpackungsmaschine verstopfte. Es war deshalb zentral, das kein Verschluss die Produktion verliess, welches die Maschine des Getränkeabfüllers verstopfte konnte. Notabene, eine Maschine produziert mehr als eine Million Verschlüsse pro Tag! Wir entwickelten ein Laser-Höhenmesssystem, welches jedes der Verschlüsse innerhalb einer hunderstel Sekunde auf Überhöhe testete, und falls ein Fehlteil gefunden wurde, dies auch auswarf.

Wie man nun solch ein System sicher herstellt, beschreiben wir Schritt für Schritt im Pdf-Guide: Secure Quality. Auf dieser Seite beschäftigen wir uns mit dem aktuellen Validieren.

Was sind die Validiermethoden?

Es werden dabei statistische Qualitätsmanagement-Methoden angewendet um einen Prozess als fähig zu validieren. Jede Produktionsmethode produziert Fehlteile! Es geht aber darum die fehlerhaften Teile auszusortieren, wie z.B. SChrauben ohne Gewinde , so dass diese nie beim Kunden ankommen.Dabei fallen häufig Ausdrücke wie Six-Sigma-Produktion oder die Langzeit-Prozessfähigkeitszahl Cpk≥ 2. Was heisst dies nun?

Das Idealbild:

Es wird meistens von einer Normalverteilung ausgegangen, welches der Formel in folgt und ausgezeichnet die folgende Figur ist:

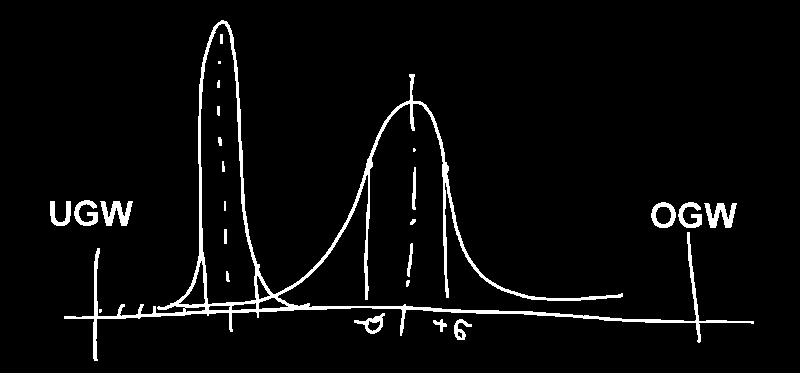

Dabei wird von der standartisierten Glockenverteilung der Produktion ausgegangen. zeigt eine korrekt berechnete Streuungsverteilung. Sie zeigt die breiteste Streuung, welche gerade noch die 6-Sigma Kriterien erfüllt. Six-Sigma heisst nichts anderes, als dass es 6 Standardabweichungen bis zum Grenzwert hat: egal ob den oberen oder unteren. Die Grenzwerte sind im Normalfall vorgegeben: entweder vom Kunden oder vom Gesetzgeber. Eine Standardabweichung ist dort, wo die Glockenkurve von linksgebogen nach rechtsgebogen wechselt (siehe gestrichelte Linie in der Graphik).

Damit stimmt muss folgendes erfüllt sein: Der Prozess ist in der Mitte zwischen den Grenzwerten zentriert. Reel gemessene Teile sind eigentlich immer mindestens 3 Sigma vom näheren Grenzwert entfernt, d.h. 99.73% von 1000 produzierten Teilen. Dabei sind nur 3 Teile pro Milion näher am Grenzwert. Und die Kernaussage von Six-Sigma: nur 2 Teile pro Million sind ausserhalb der Grenzwerte (99.9999998% der Produktion ist innerhalb der Grenzwerte und somit gut.)

Die Standardabweichung folgt der . Um sie von Hand auszurechnen ist ziemlich unhandlich. Einfacher benutzt man Excel mit der Formel "=STABWN (Bereich)". Der Autor von diesen Zeilen hat auch noch nie die Standardabweichung von Hand berechnet, also scheuen Sie sich nicht Excel zu verwenden.

Soweit so gut das mathematische Weltbild. In der Wirklichkeit aber treten doch einige Probleme auf, welche wir nun Ihnen darlegen wollen, damit Sie die Validierung Ihrer Anlage besser planen können.

Keine symmetrische Verteilung

In der Realität gibt es normalerweise keine symmetrische Verteilung der Produktion zu den zwei Grenzwerten, wie in die linke Glockenkurve zeigt, welche zum unteren Grenzwert (UGW) verschoben ist. Jedoch auch da lässt sich eine Six-Sigma Produktion aufbauen, indem man den Prozess stabiler macht, d. h. die Glockenkurve wird höher im Zentrum. Dies heisst im Endeffekt, dass die Teile viel genauer produziert werden müssen.

Zu wenig Samples

Das häufigste Problem der Validierung ist, dass der Kunde zu wenig Testmaterial zur Verfügung stellt: entweder weil die Muster sehr teuer sind, oder weil es noch gar keine Muster gibt, weil die vorgeschaltete Maschine noch gar nicht gebaut ist. So erhalten wir häufig weniger als 100 Muster zum Testen der Maschine. Mit 100 Teilen lassen sich jedoch keine Aussagen über 1 Million Teile machen! zeigt dass bei 100 Tests nur einmal 0.02% die Wahrscheinlichkeit ist, dass überhaupt ein falsches Teil produziert wird. Kurzum, wenn man mit nur 100 Teilen die Maschine validert, so müssen alle Teile perfekt sein! Oder anders gesagt, wenn wir eine Streuung haben, so müssen alle Teile innerhalb von 1 Standardabweichungen sein. Wenn dies nicht erreicht wird, so muss die Validierung abgebrochen werden und die Maschine nachgearbeitet werden.

Nur Gut/Schlecht

Viele Produktionsprozesse sind nicht kontinuierlich in der Verteilung der Abweichung, sondern binär. Das heisst das Teil ist entweder gut oder schlecht.

Eine Anwendung ist ein Messdorn, welcher entweder in das Loch hineingeht (=gut) oder eben nicht (=schlecht). Diese Verteilung kann nicht mit der Normalverteilung dargestellt werden, sondern folgt der Binominalverteilung.

Die Binominalverteilung ist für kleine Werte von n und k gut brauchbar. Für grosse Werte von n, wie sie in der Qualitätssicherung vorkommen sind wegen der Fakultät im Term nicht brauchbar. Bereits bei n=100 Teile muss bereits 100! berechnet werden muss. Um sich ein Bild davon zu machen, was 100! heisst, hier fertig ausgerechnet:

100!=93326215443944152681699238856266700490715968264381621468592963895217599993229915608941463976156518286253697920827223758251185210916864000000000000000000000000

Man sieht auf den ersten Blick, dass dies jede normale Software überfordert.

Zum Glück gibt es aber eine Annährung für grosse Quantitäten (n), und kleinen Fehlerquoten (p). Dies ist die Poisson-Verteilung.

Die Poisson-Verteilung hat für kleine Werte von λ eine stark asymmetrische Gestalt. Für größer werdendes np wird die Poison-Kurve symmetrischer und ähnelt ab etwa np > 30 einer gaußschen Normalverteilung mit μ = np und σ2 = np. Bei der Null-Fehler Fertigung wird die Bedingung von np > 30 locker erreicht, was heisst, wir dürfen auch hier mit der Normalverteilung approximieren.

Abhängige Variabeln

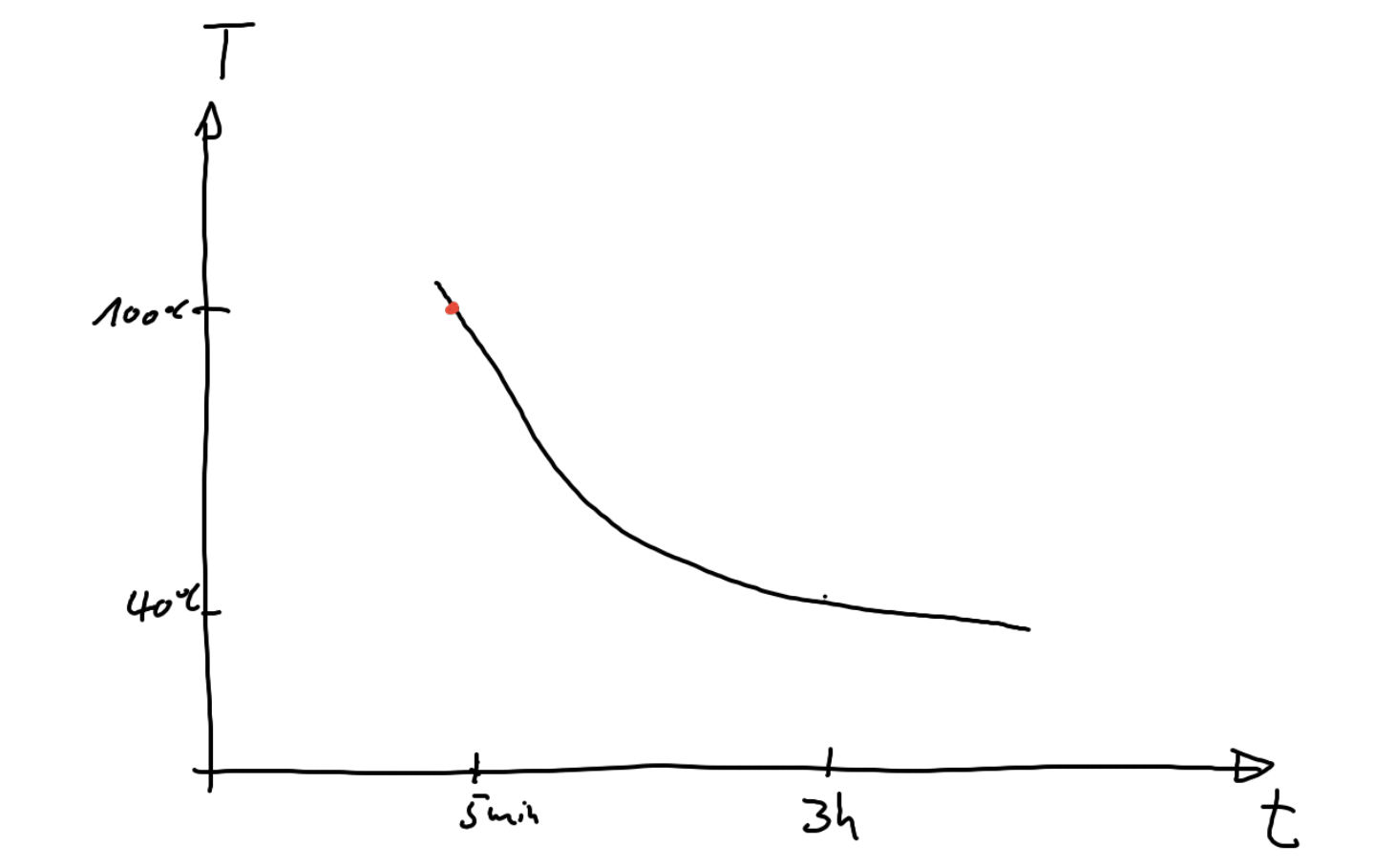

Bis jetzt gingen wir immer von unabhängigen Variabeln aus, d.h. wenn man einen Wert verändert, dann hat es keine weiteren Einflüsse auf die Maschine. Der häufigste und einer der schwierigsten Prozesse sind Herstellmethoden, welche von der Wärme abhängig sind. Ein einfaches Beispiel, dass jeder kennt: "Eierkochen". Die Härte des Eies ist abhängig von der Einwirkzeit (t) und von der Temperatur (T), also der zugeführten Wärmeenergie (W), da ja gilt W=T*t . Je höher die Temperatur, umso weniger lang muss das Ei kochen. Das heisst die Zeit und die Temperatur sind umgekehrt voneinander abhängig.

Jeder kennt den roten Punkt in . Ein perfektes Ei (aus Sicht des Autors) braucht 5 Minuten unter Standardbedingungen (kochendes Wasser auf Meereshöhe, d.h. T=100C). Nun kann man den Prozess verschnellern, indem man die Temperatur erhöht (Ei in die Mikrowelle oder Dampfkochtopf). Sehr schnell gelangt man an den Punkt, wo das Ei explodiert, d.h. sinnvolles Eierkochen ist nicht mehr gewährleistet (unterster möglicher Grenzwert für die Zeit, höchster für die Temperatur). Auf der anderen Seite der Zeitskala, d.h.wenn man mehrere Stunden investiert, so kann man auch bei sehr niedrigen Temperaturen (50-60C) noch ein Ei zum hartwerden bringen. Aber es gibt eine untere Grenztemperatur, unterhalb derer es nicht mehr möglich ist.

Das Beispiel des Eies ist sehr eindrücklich, da es die volle Komplexität von Wärmeprozessen darstellt: Es ist nicht linear, es gibt natürliche untere und obere Grenzwerte. Das ginge ja noch, aber eine kleine Reduktion der Temperatur bringt eine extreme Verlängerung der Zeit (und eine Stabilisierung des Prozesses), währenddem eine kleine Erhöhung der Temperatur die Zerstörung der Eies zur Folge hat.

Was ist nun die perfekte Temperatur für solch einen Prozess? Ganz einfach: stabil und trotzdem noch in einem "vernünftigen" Zeitrahmen (d.h. 5 min für Eier bei 100C). Leider funktionieren bei nichtlinearen Prozessen mit mehreren Variablen die vereinfachenden QS Modelle wie cpk und 6-Sigma nur begrenzt. Da müssen auch wir den gesunden Menschenverstand walten lassen und einen sinnvollen Wert experimentell suchen, und dann mit den QS Methoden validieren, mathematisch geht das nicht!